Certyfikat Databricks

Witam wszystkich gorąco i serdecznie, ten wpis będzie dotyczył certyfikacji a konkretnie Certyfikatu Databricks. Postawiłem sobie za cel, że zdobędę ten certyfikat. Są różne opinie na rynku dotyczące certyfikatów w IT. Jedni są za a inny przeciw i na pewno każdy ma racje po swojej stronie i konkretne argumenty. Nie mniej jednak posiadanie certyfikatów ma swoje zalety a najważniejsze dla mnie to usystematyzowanie wiedzy i pokazanie, że poważnie się podchodzi do danej technologii. Poza tym będę wiedział jak trudy, jest taki certyfikat. Od kolegi, który go zdawał dowiedziałem się, że trzeba być dobrze przygotowanym do certyfikatu Databricks i czasu na myślenie nie ma za dużo i trzeba znać się na rzeczy. Aczkolwiek zdawał on stary egzamin, który w tym roku jest już inny.

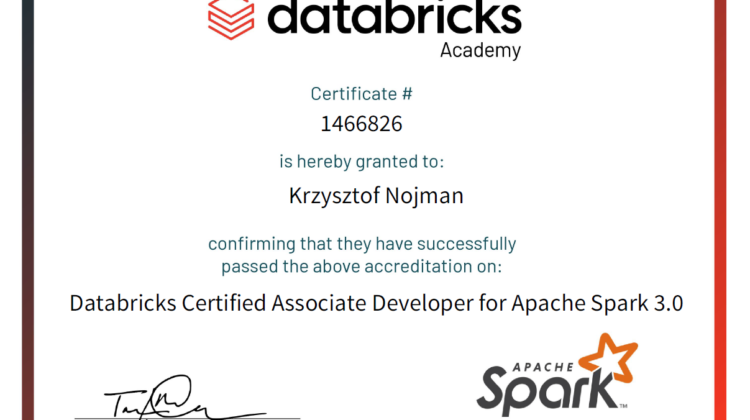

Jak na razie zdobyłem już dwa, są to darmowe i bardzo proste kursy, które można przerobić w kilka godzin, ale przynajmniej otrzymałem za zachętę ładny papierek. Muszę przyznać, że trochę motywuje.

Już zacząłem zbierać materiały i działam codziennie, żeby cały czas poznawać Sparka i Databricks.

Certyfikat Databricks

Właśnie zauważyłem, że Databricks zmienił certyfikację od 01 Listopada 2019. Trochę mnie to cieszy, ponieważ historycznie Certyfikat Databricks CRT010: Databricks Certified Developer: Apache Spark™ 2.X kosztował $300 i obejmował znacznie więcej tematów. Obecnie został podzielony na dwa oddzielne egzaminy i do tego cena spadła do $200, więc jak można sobie go odmówić 🙂

- Databricks Certified Associate Developer for Apache Spark 2.4

- Databricks Certified Associate ML Practitioner for Apache Spark 2.4

Poniżej znajdziecie dwa zestawienia wszystkich elementów egzaminu. Pierwsza część starego egzaminu i druga z nowszej serii. Będę zbierał i dodawał materiały i linki jak tylko znajdę coś ciekawego. Polecam sprawdzać materiały na Git-hub tam też będę wrzucał trochę kodu. Wiec polecam odwiedzać tą stronę.

CRT010: Databricks Certified Developer: Apache Spark™ 2.X

Zdaje sobie sprawę z tego że ten Certyfikat Databricks jest już nieaktualny ale pokazuje co trzeba wiedzieć aby dobrze opanować Sparka.

Certification Exam Scope

- Understanding breadth of Spark API usage

- Understanding DataFrame API usage

- Applying best practices to avoid runtime issues and performance bottlenecks

- Scaling Spark Applications through API features and architecture

- Integrating Streaming, ML, GraphFrames atop the Spark unified engine

- Solving typical use cases

Exam Topic Areas

- 30% – Spark Architecture and Run-time Behavior

- Caching – cache(), persist(), unpersist(), and storage levels

- Partitioning

- Initial DataFrame partitioning when reading from data source

- Repartitioning via coalesce() vs repartition()

- Controlling number of shuffle partitions

- Performance

- Catalyst optimizer

- Identifying performance bottlenecks in Spark applications

- https://spark.apache.org/docs/latest/sql-performance-tuning.html

- https://databricks.com/session/understanding-the-performance-of-spark-applications

- https://databricks.com/blog/2018/01/09/databricks-cache-boosts-apache-spark-performance.html

- https://databricks.com/session/improving-python-and-spark-performance-and-interoperability

- https://databricks.com/training/instructor-led-training/courses/apache-spark-tuning-and-best-practices

- https://databricks.com/session/tuning-apache-spark-for-large-scale-workloads

- 40% – Spark SQL and DataFrame/DataSet Manipulation

- Reading and writing DataFrames

- Transformations, actions, and other operations

- https://docs.databricks.com/spark/latest/dataframes-datasets/introduction-to-dataframes-scala.html

- Wide vs narrow transformations

- Joins

- https://jaceklaskowski.gitbooks.io/mastering-spark-sql/spark-sql-joins.html

- https://databricks.com/session/optimizing-apache-spark-sql-joins

- Supported Types

- Broadcast Joins

- Cross Joins

- Defining and using User Defined Functions (UDFs)

- Window functions

- 10% – RDDs and Low-Level APIs

- Basic RDD and PairRDD operations

- Transformations, such as map(), flatMap(), mapValues()

- Aggregations

- Actions

- Joins

- RDD <-> DataFrame conversions

- Accumulator & AccumulatorV2

- Wide Transformations, such as reduceByKey(), groupByKey() etc..

- Basic RDD and PairRDD operations

- 10% – Structured Streaming

- No legacy DStream API coverage

- Standard sources and sinks

- Fault tolerance guarantees

- Streaming DataFrame manipulation

- Aggregation, including using time windows

- Watermarking

- Checkpointing

- < 5% – Machine Learning

- No legacy RDD-based APIs coverage

- ML Pipeline basics

- Initial DataFrame

- Transformers

- Estimators

- Model selection

- Evaluators

- Parameter grids

- No knowledge about specific algorithms is required

- < 5% – GraphFrames

- No GraphX coverage

- Creating a GraphFrame instance

- Basic GraphFrame operations

- inDegrees(), outDegrees()

- bfs(), shortestPaths()

- triangleCount()

- No knowledge about specific algorithms is required

- Key API Classes

- SparkSession

- DataFrame and DataSet

- DataFrameReader and DataFrameWriter

- Column and Row

- org.apache.spark.sql.functions

Databricks Certified Associate Developer for Apache Spark 2.4

- have a basic understanding of the Spark architecture

- be able to apply the Spark DataFrame API to complete individual data manipulation task, including:

- selecting, renaming and manipulating columns

- filtering, dropping, sorting, and aggregating rows

- joining, reading, writing and partitioning DataFrames

- working with UDFs and Spark SQL functions

Tutaj Databricks rekomenduje kurs DB 105 – Apache Spark™ Programming

Muszę przyznać, że jestem trochę rozczarowany przy poprzednim kursie było dokładnie rozpisane jakie są wymagania. Teraz jest bardziej ogólnie, czyżby było mało chętnych więc Databricks upraszcza żeby nie odstraszać ?

Co jest w kursie to powinno wystarczyć żeby dostać 5, mam taka nadzieję.

- About Databricks, Spark

- A high-level overview of the Spark Architecture

- Spark Entry Points, Simple Data Injestion & overview of API docs

- Hands-on practice with different data injestion options

- Hands-on practice with the DataFrames APIs

- Introduction to Spark’s execution model

- Hands-on practice with performance optimization

- Introduction to Structured Streaming

- Introduction to Machine Learning Pipelines

Co myślicie o takim certyfikacie, jakie są wasze doświadczenia ?

Na razie nie mam opinii, ale robię ten certyfikat i jeśli się mi powiedzie to powiem

Bez wchodzenia w za i przeciw, bez wątpienia klienci na to patrzą. Powodzenia