Jeśli pracujesz z Databricks, to powinieneś znać Databricks CLI, służy do wydawania poleceń i kontroli środowiska roboczego w Databricks. Dzięki niemu jesteś w stanie zarządzać obszarem roboczym w Databricks, gdzie są hostowane klastry Apache Spark, notatniki biblioteki, joby, ect.

Co to jest Databricks cli

Jak wskazuje nazwa Command Line Interface jest narzędziem, które działa w terminalu na twoim komputerze. Są to komendy wykonujące konkretne zadania. Działa ono tak samo na Windows, Mac i Linux.

Jest to narzędzie typu open-source hostowane na gitHub, więc jeśli chcesz, to możesz przejrzeć kod źródłowy.

Kiedy używać

Możesz usprawnić swoją pracę i sprawić, że będziesz bardziej produktywny. Do tego oszczędzisz czas, a tego zawsze jest za mało 😥. Podstawową zaletą narzędzi typu command line, jest ich prostota, a jednocześnie spore możliwości. Wiem to brzmi jak administracja, ale uważam, że warto je znać i korzystać zgodnie z przeznaczeniem. Może być przydatne dla każdego od Developera do DevOpsa.

Najważniejszą zaletą jest szybkość, prostota i możliwość automatyzacji. Można te same operacje wykonać w portalu, ale uważam, że część z nich można wykonać w terminalu i to całkiem efektywnie. Nie trzeba czekać 5 minut, żeby przejrzeć, jakie dane są w folderach.

Nie ważne co ja myślę sprawdź, zobacz jak działa może się okazać przydatne.

Kiedy są przydatne.

- Kiedy będziesz chciał stworzyć klaster już skonfigurowany.

- Kiedy chcesz sprawdzić jakie masz dane.

- Kiedy chcesz uruchomić job.

- Kiedy chcesz zobaczyć jakie masz notatniki.

- Kiedy chcesz importować lub eksportować notatniki.

- Kiedy chcesz zainstalować paczki jar lub wheel.

……. Jest tego dużo, pełna lista poniżej.

Pełna lista możliwośći

Ta lista pochodzi z oficjalnej dokumentacji więc możesz na niej polegać.

- Cluster Policies CLI

- Clusters CLI

- DBFS CLI

- Delta Live Tables CLI

- Groups CLI

- Instance Pools CLI

- Jobs CLI

- Libraries CLI

- Repos CLI

- Runs CLI

- Secrets CLI

- Stack CLI

- Tokens CLI

- Unity Catalog CLI

- Workspace CLI

Dostępne komendy:

| Komenda | Opis |

| cluster-policies | Możliwość zmian polityk klastra. |

| clusters | Tworzenie i modyfikowanie klastrów. |

| configure | Konfiguracja narzędzia CLI, czyli dodawanie adresu url oraz tokena. |

| fs | Możliwość przeglądania folderów w DBFS. |

| groups | Zarządzanie grupami. |

| instance-pools | Tworzenie i zarządzanie Databricks instance pools. |

| jobs | Zarządzanie mechanizmem jobs. |

| libraries | Zarządzanie bibliotekami. |

| pipelines | Zarządzanie procesem ETL Databricks Delta Pipelines. |

| repos | Ustawianie i konfiguracja repozytorium |

| runs | Zarządzanie procesem jobs runs. |

| secrets | Dostęp to sekretów Databricks API |

| stack | [Beta] Zarządzanie i pobieranie Databricks resource stacks |

| tokens | Interakcja z tokenami Databricks tokens. |

| unity-catalog | Interakcja z Databricks Unity Catalog. |

| workspace | Zarządzanie środowiskiem roboczym Databricks workspace. |

Terminal

Takie proste narzędzie, a ile daje radości i jak pomaga w życiu.

Jak już tak rozmawiamy o terminalach to polecam się zapoznać z Windows Terminal bo jest świetny i bardzo pomaga w codziennej pracy. Jest do pobrania w Microsoft Store. Instrukcje jak można skonfigurować Windows Terminal.

Jak zacząć korzystać z Databricks CLI

Na szczęście dla Ciebie instalacja jest bardzo prosta. Link do oficjalnej dokumentacji.

- Sprawdź czy masz zainstalowanego Pythona w wersji co najmniej 3.6

python --version

Jeśli nie to wejdź na oficjalną stronę Python.org i go zainstaluj. Pamiętaj żeby wybrać opcję i dodać pip.

- Sprawdź czy masz zainstalowane narzędzie do zarządzania paczkami – pip? Jeśli instalowałeś Python w poprzednim kroku to powinien tam być. Zawsze możesz go dodać.

pip --version

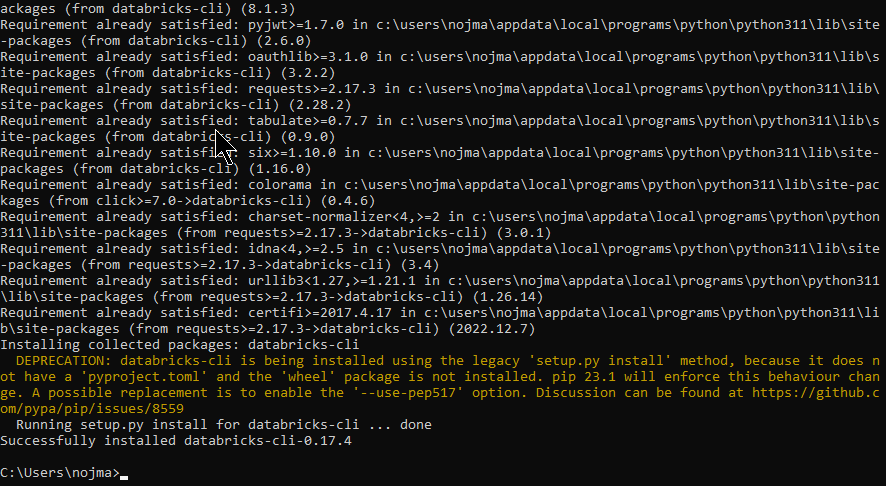

- Jeśli masz te trzy warunki to możesz instalować Databricks CLI

pip install databricks-cli

- Teraz czas na konfigurację dostępu. Potrzebujesz dwóch informacji

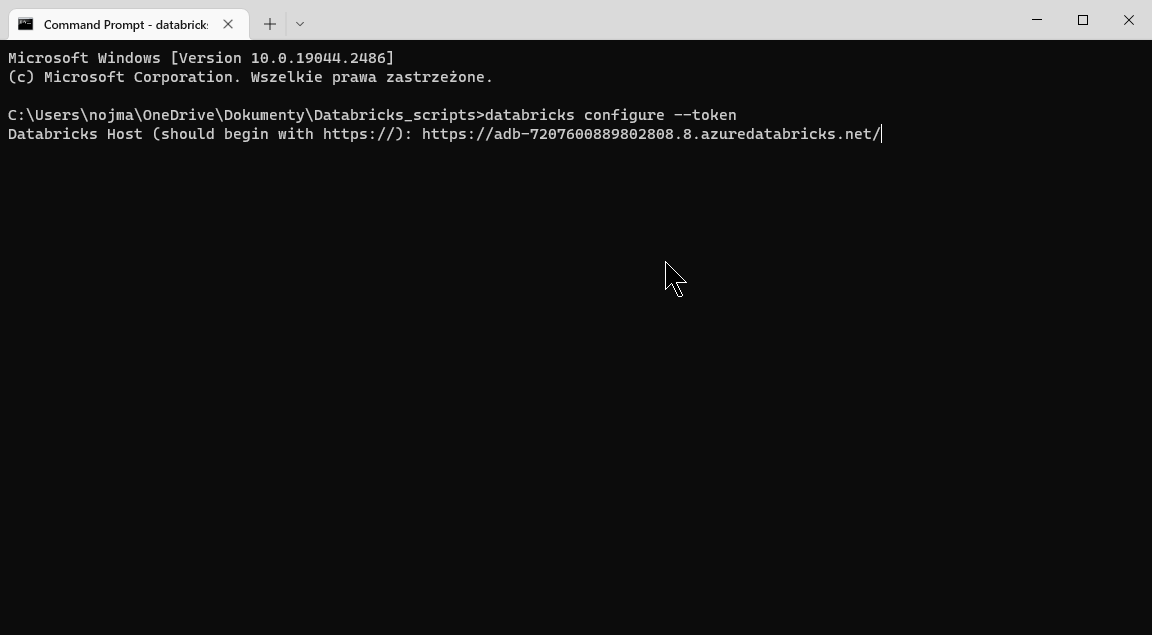

- Adress URL workspace https://adb-7907630882506808.8.azuredatabricks.net/

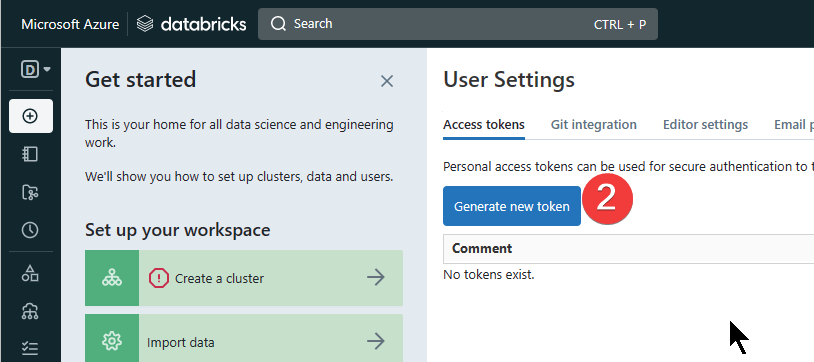

- Token wygenerowany w Databricks workspace

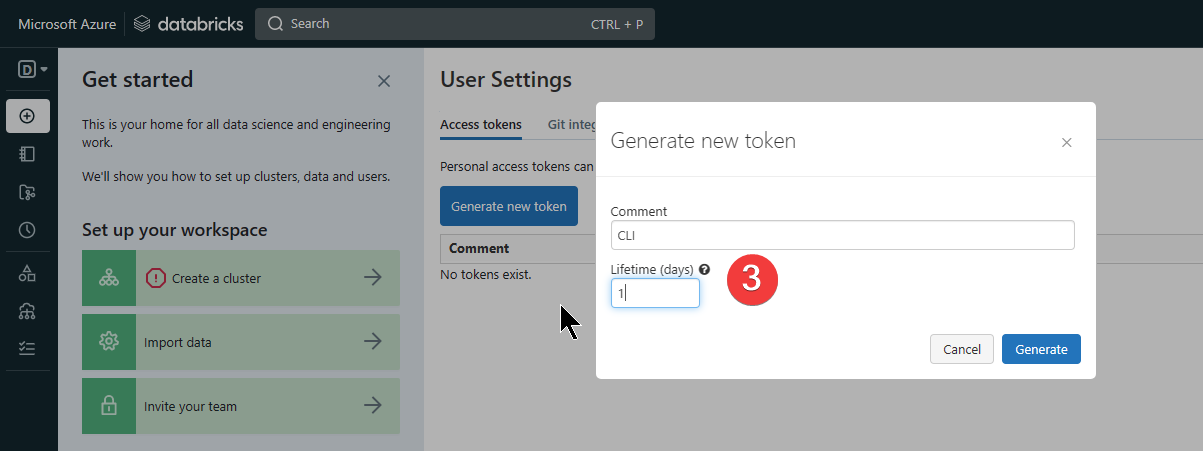

- Ścieżka do tokena: Databricks workspace > twój email@ > User Settings > Generate New Token

- Czas na konfigurację CLI – podaj URL i token z poprzedniego kroku

databricks configure --token

- Czas sprawdzić czy działa

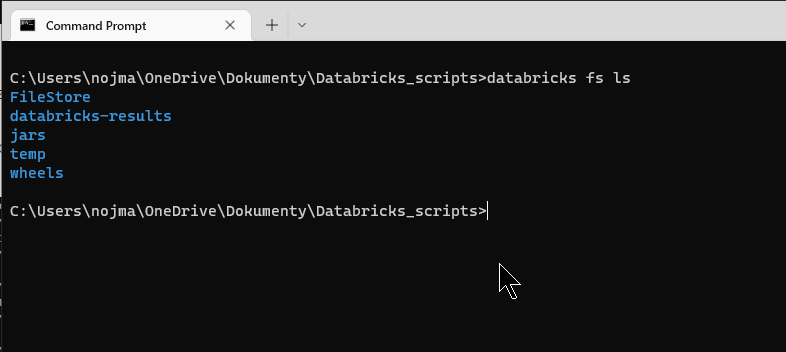

Możesz sprawdzić zawartość folderów

databricks fs ls

Ważne

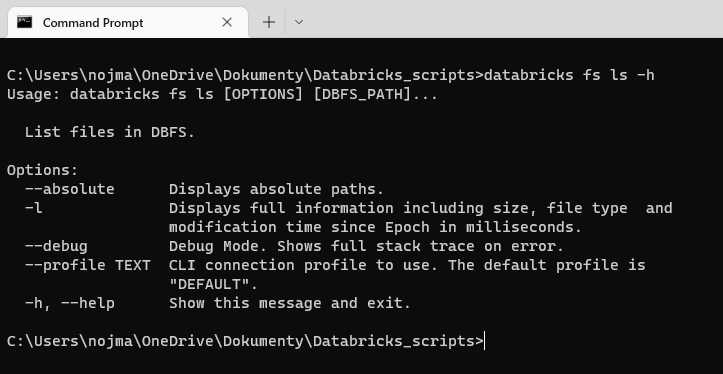

Dla każdej komendy jest dostępna pomoc wystarczy dodać „-h” i zobaczysz podpowiedź.

Zalety

Najważniejszą korzyścią jest oszczędność czasu, podczas prac deweloperskich nie muszę wchodzić na workspace czy czekać aż klaster się uruchomi. Mogę np. sprawdzić jakie mam pliki i konfigurację bardzo szybko i wygodnie.

Jest też sporo elementów codziennej pracy, którą możesz zautomatyzować i tu też oszczędzisz cenny czas. Polecam sprawdzić. Zacznij go używać i sam się przekonasz czy warto.

Jakie masz metody na efektywną pracę z Databricks?